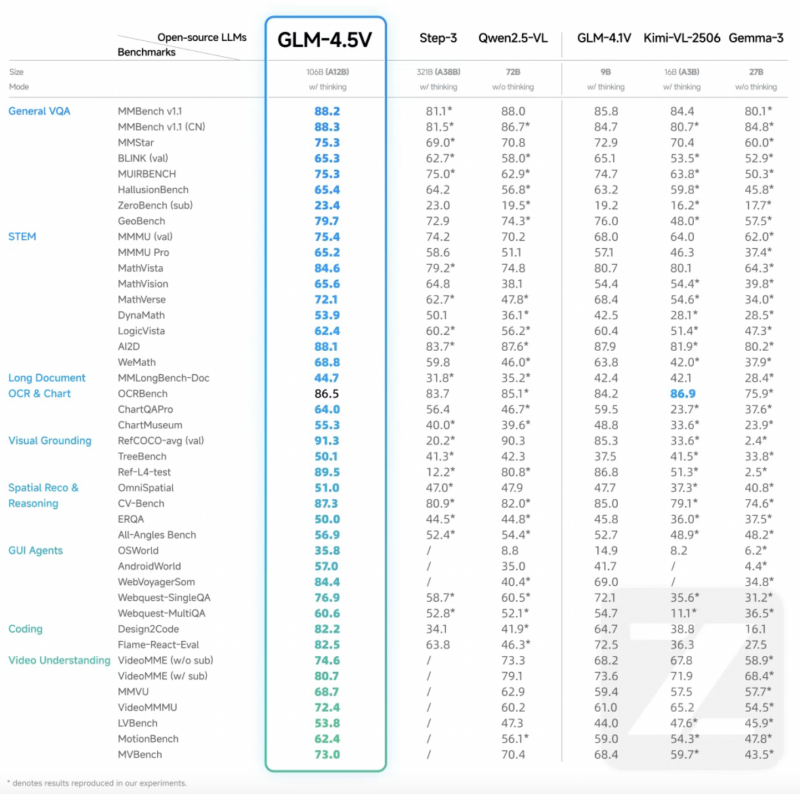

8月11日晚,智谱AI发布全球100B级效果最佳的开源视觉推理模型GLM-4.5V(总参数 106B,激活参数 12B),并同步在魔搭社区与Hugging Face开源。

多模态推理被视为通向通用人工智能(AGI)的关键能力之一,让AI 能够像人类一样综合感知、理解与决策。其中,视觉-语言模型(Vision-Language Model, VLM)是实现多模态推理的核心基础。

今年7 月,智谱AI发布并开源了全球10B级效果最强的VLM——GLM-4.1V-9B-Thinking。该模型以小搏大,展现了小体积模型的极限性能潜力,上线后迅速登上Hugging Face Trending榜首,并累计获得超过13 万次下载。

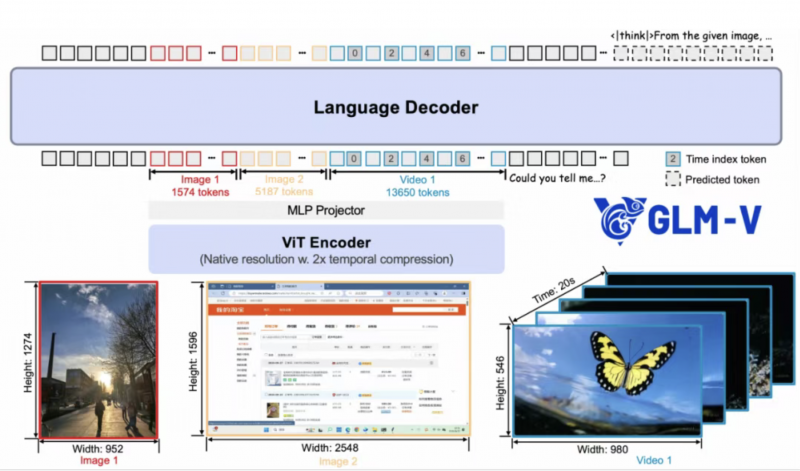

此次发布的GLM-4.5V通过高效混合训练,具备覆盖不同种视觉内容的处理能力,实现全场景视觉推理,包括:图像推理(场景理解、复杂多图分析、位置识别)、视频理解(长视频分镜分析、事件识别)、GUI任务(屏幕读取、图标识别、桌面操作辅助)、复杂图表与长文档解析(研报分析、信息提取)、Grounding能力(精准定位视觉元素)等。同时,模型新增“思考模式”开关,用户可灵活选择快速响应或深度推理,平衡效率与效果。

为了帮助开发者打造专属于自己的多模态应用,智谱AI同步开源了一款桌面助手应用。该桌面应用可实时截屏、录屏获取屏幕信息,并依托GLM-4.5V处理多种视觉推理任务,日常处理如代码辅助、视频内容分析、游戏解答、文档解读等多类视觉任务,成为一个能看着屏幕和你一起工作娱乐的伙伴。

在视觉定位方面,GLM-4.5V能够根据用户提问,精准识别、分析、定位目标物体并输出其坐标框。该能力在现实世界拥有广阔的应用场景,例如安全与质量检查、高空遥感监测分析。相较于传统的基于视觉模型的物体识别,GLM-4.5V凭借更丰富的世界知识与更强大的语义理解能力,能够通过推理来理解更复杂的定位指令。

在前段复刻方面,GLM-4.5V具备强大的推理与代码生成能力,能够对上传的网页截图进行分析,并将其转化为结构化的网页代码。与简单的图像元素识别不同,GLM-4.5V能够深入理解并推断元素间的逻辑关系、布局规则和交互意图,从而生成高度准确且功能完整的网页代码。

在图像识别与推理方面,GLM-4.5V具备强大的感知与推理能力。一个典型应用是,在不依赖搜索工具的情况下,模型能通过图像中的细微线索来推理出背景信息。例如,上传任意风景或街拍图片后,GLM-4.5V可分析植被特征、气候痕迹、建筑风格等要素,精准推测图片拍摄地点及大致经纬度。

在复杂文档深度解读方面,GLM-4.5V可以阅读长达数十页、含有大量图表的复杂长文本,能够对文本进行总结、翻译、图表提取等操作;此外,还能在给定信息的基础上输出自己的"观点"。与传统的OCR信息提取+文本模型解读的方式不同,GLM-4.5V会像人类一样,以视觉方式读取文档中的每一页图片,避免了信息提取过程中的错误传递,实现了文字与图像的同时理解,因此对于图表、表格等视觉化、结构化信息的保留和解读会更加准确。

价格方面,GLM-4.5V兼顾推理速度与部署成本,为企业与开发者提供高性价比的多模态AI 解决方案。API调用价格低至输入2 元/M tokens,输出6 元/M tokens。响应速度达到60-80 tokens/s。

文/北京青年报记者 温婧

编辑/周超