近日,一场斯坦福大学AI项目团队抄袭中国大模型公司开源产品的闹剧,在AI新时代下,为中美技术追赶局势按下刷新键。

由于斯坦福大学AI团队主导的Llama3-V开源模型,被迅速证实套壳抄袭国内清华与面壁智能的开源模型“小钢炮”MiniCPM-Llama3-V 2.5,北京时间6月4日1点27分,两位作者森德哈斯·沙玛(Siddharth Sharma)和阿克沙·加格(Aksh Garg)在社交平台X上就这一行为向面壁MiniCPM团队正式道歉,并表示会将Llama3-V模型撤下。

在面壁智能首席科学家、清华大学长聘副教授刘知远看来,2006年行业从业者的主要目标还是在国际顶级会议上发表一篇论文。尽管这次以一种令人遗憾的方式揭示了中国AI研发的较高水平,但也说明,现如今中国创业公司的大模型产品开始受到国际的广泛关注与认可。

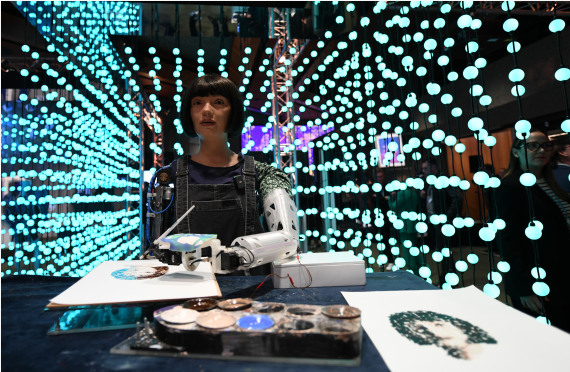

5月30日,在瑞士日内瓦举行的2024年“人工智能造福人类全球峰会” 上,绘画艺术家机器人Ai-Da在画画。新华社

抄袭动作被迅速证实

梳理时间线可知,事件最早起始于5月29日,一个来自斯坦福大学的AI团队开始在网络上宣传500美元就能训练出一个SOTA(“最新技术”的最佳状态)多模态模型。

作者声称Llama3-V比GPT-4V、Gemini Ultra、Claude Opus性能更强。团队成员是来自斯坦福大学的本科生,曾发表多篇机器学习领域论文,实习经历包括AWS、SpaceX等。由于亮眼的背景,Llama3-V项目很快冲到HuggingFace(一个开发者社区和平台)首页,并引发开发者群体的关注。

一位用户在社交平台X与HuggingFace上质疑Llama3-V是否套壳MiniCPM-Llama3-V 2.5,后者为面壁智能推出的开源端侧多模态模型,于2024年5月21日发布。

Llama-3V团队彼时回应,他们只是使用了MiniCPM-Llama3-V 2.5的tokenizer(分词器,自然语言处理中的一个重要组成部分),并在MiniCPM-Llama3-V 2.5发布前就开始了这项工作。但团队并未解释如何做到在MiniCPM-Llama3-V 2.5发布之前就获取了详细tokenizer的具体方式。

随后,关于上述AI团队抄袭的声音越来越多。如Llama3-V的模型结构和配置文件与MiniCPM-Llama3-V 2.5完全相同,只是进行了一些重新格式化并将部分变量重新命名。Llama3-V也具有与MiniCPM-Llama3V 2.5相同的分词器,包括MiniCPM-Llama3-V 2.5新定义的特殊符号。

HuggingFace页面显示,最初Llama3-V的作者在上传代码时直接导入了面壁智能MiniCPM-V的代码,然后将名称更改为Llama3-V。但作者之一的穆斯塔法·阿尔贾德里(Mustafa Aljadery)并不认为该行为属于抄袭。他发文称,Llama3-V推理存在bug,他们只是使用了MiniCPM-V的配置来解决bug,并不是抄袭。“架构是基于综合研究的,你怎么能说它是MiniCPM呢?MiniCPM代码的视觉部分看起来也是从Idéfics那里使用的。”

在面壁智能CEO李大海看来,另一证据在于Llama3-V同样使用了面壁智能团队新设置的清华简(清华大学于2008年7月收藏的一批战国竹简)识别能力,且呈现的做错案例都与MiniCPM一模一样,而这一训练数据尚未完全公开。更加微妙的是,两个模型在高斯扰动验证(一种用于验证模型相似性的方法)后,在正确和错误表现方面都高度相似。

在最新的进展中,斯坦福Llama3-V团队的两位作者在社交平台上向面壁MiniCPM团队正式道歉。阿克沙·加格表示:“首先,我们要向MiniCPM原作者道歉。我、森德哈斯·沙玛,以及穆斯塔法一起发布了Llama3-V。穆斯塔法为这个项目编写了代码,但从3日起就无法联系他。我与森德哈斯·沙玛主要负责帮助穆斯塔法进行模型推广。我们俩查看了最新的论文,以验证这项工作的新颖性,但并未被告知或意识到OpenBMB(清华团队支持发起的大规模预训练语言模型库与相关工具)之前的任何工作。我们向作者道歉,并对自己没有努力验证这项工作的原创性感到失望。我们对所发生的事情承担全部责任,并已撤下Llama3-V,再次致歉。”

抄袭后呈现的错误也一样,GT为正确答案

大模型时代中国迅速追赶

对于此次抄袭闹剧,斯坦福人工智能实验室主任曼宁(Christopher David Manning)发文谴责,并对MiniCPM这一中国开源模型表示赞扬。

李大海表示:“我们对这件事深表遗憾。一方面感慨这也是一种受到国际团队认可的方式,另一方面呼吁大家共建开放、合作、有信任的社区环境。”

目前全球大模型竞争格局呈现出多元化的特点。美国大模型数量和技术水平呈领先态势,包括自然语言处理、计算机视觉、语音识别领域,以及AI芯片、云计算基础设施等方面。但中国大模型在应用场景、算法优化、数据资源等方面具有优势。

据IT桔子数据,目前,中国人工智能领域的独角兽公司共有102家,其中2023年新晋独角兽有10家,AIGC及大模型相关有4家,占比近一半,具体包括智谱AI、百川智能、零一万物、Minimax名之梦。

此前在采访中谈及中美大模型领域的差距,零一万物董事长兼CEO李开复表示,一年前,中国大模型与OpenAI、Google启动大模型研发的时间点比起来,有7到10年的差距;但如今,中美之间的差距正在不断缩小,目前约为6个月。

刘知远因此次被抄袭事件回忆了过去十几年间,科研经历的“斗转星移”:2006年刘知远读博时,计算机、人工智能行业从业者的主要目标是在国际顶级会议上发篇论文;2014年,刘知远开始做老师,彼时只有获得国际著名会议的最佳论文等重要成果,才有机会登上系里的新闻主页;2018年语言表示模型BERT面世,科研团队看到了它的变革意义,并做出知识增强的预训练模型ERNIE,发表在ACL(计算语言学协会)2019年会,这样的成果在当时已经算站到国际前沿了;2020年,OpenAI发布了1700+亿参数GPT-3,从业者清醒认识到与国际顶尖成果的差距,知耻而后勇开始了“大模型”的探索;2022年底,OpenAI推出ChatGPT,让大众真切感受到AI领域国内外的差距,特别是2023年Llama等国际开源模型发布后,开始有“国外一开源、国内就自研”的说法。

到了2024年的今天,刘知远表示,行业从业者也应该看到国内大模型团队如智谱-清华GLM、阿里Qwen、DeepSeek和面壁-清华OpenBMB等,正在通过持续的开源共享,在国际上受到广泛的关注和认可,这次事件也算侧面反映国内创新成果受到的国际关注。

单模态之外,今年4月,清华大学人工智能研究院副院长、生数科技联合创始人兼首席科学家朱军教授代表清华大学与生数科技,发布中国首个视频大模型Vidu,被视作中国版Sora(OpenAI发布的多模态大模型)。

启明创投合伙人周志峰表示,如今的大模型已从原来的纯语言模态逐步走向多模态的探索。生数科技大量工作被OpenAI、Stable Diffusion团队引用。生数科技CEO唐家渝认为,多模态大模型的研究仍处于起步阶段,技术成熟度还不高。这一点不同于火热的语言模型,国外已经领先了一个时代。因此,相比于在语言模型上“卷”,唐家渝认为多模态更是国内团队抢占大模型赛道的一个重要机会。

北京智源人工智能研究院副院长兼总工程师林咏华持有更严谨的态度,她对第一财经记者表示,中国在多模态领域弯道超车是有一定可能性的,但更关键的还是看多模态模型成功要素——依然是算力、算法和数据。目前算法层面,中美团队之间差异没有那么大,算力也不会造成最大问题,行业仍有办法去解决算力问题。但是,林咏华认为目前数据的问题是阻力最大的,即使智源一直在做AI训练数据扩展,但要获取海量高质量数据,依然难度很大。

编辑/樊宏伟