人工智能巨头开始进一步考量如何保证AI生成内容的真实性。

当地时间5月7日,OpenAI发布一款图像检测分类器,能够区分非人工智能生成的图像和DALL-E 3生成的图像,能正确识别约98%的DALL-E 3生成图像。

OpenAI表示,该分类器还可以处理常见的修改,如压缩、裁剪和饱和度变化。不过,其他修改则会降低分类器的性能。同时,分类器在区分文生图大模型DALL-E 3与其他AI模型的生成内容方面性能也较低,在内部数据集上只标记了约5%-10%由其他AI模型生成的图像。

目前,该分类器仅向第一批测试者开放使用申请。

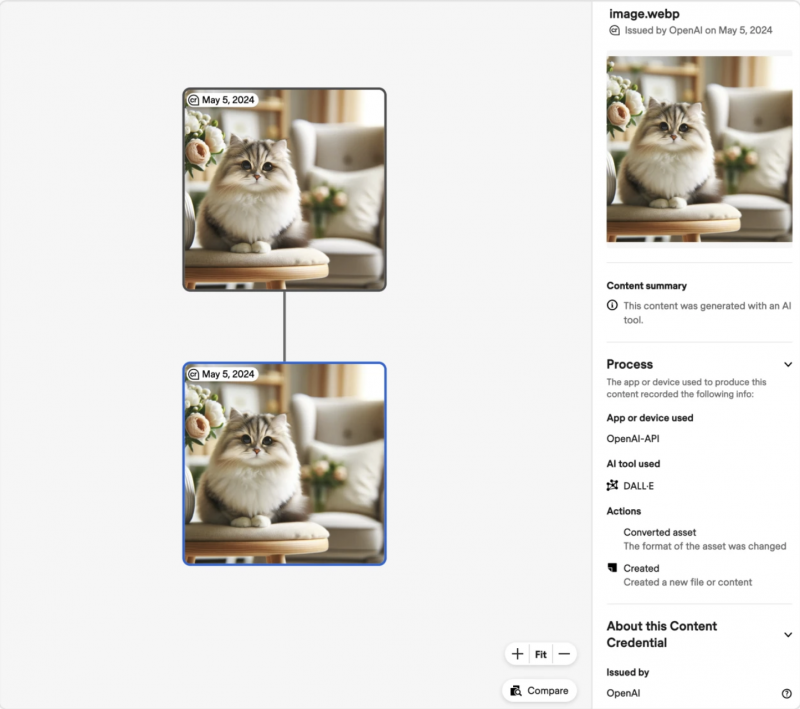

OpenAI的图像检测分类器界面

此外,OpenAI还提及了音频水印技术,不过目前仍处于研发阶段。OpenAI表示,增加防篡改水印,在音频数字内容上标记难以去除的隐形信号,也将确保数字内容的完整性。

OpenAI也强调,创建新技术目前是为了专门帮助识别由OpenAI自己的工具创建的内容,此外还要与其他公司一起采用、开发和推广一种开放标准,帮助人们验证用于创建或编辑多种数字内容的工具。

为此,OpenAI宣布加入C2PA(内容真实性联盟)指导委员会。据介绍,C2PA是一个被广泛采用的数字内容认证标准,由软件公司、相机制造商和在线平台等众多参与者开发和使用,可用于证明内容来自特定来源。微软、Meta、谷歌等也是C2PA指导委员会的成员。

OpenAI表示,今年早些时候就已开始在ChatGPT和OpenAI API中为由DALL-E 3创建和编辑的所有图片添加C2PA元数据。并且将会在Sora推出时,也为模型整合C2PA元数据。

据称,这些信息无法被轻易伪造或篡改,随着标准采用率的提高,可以覆盖内容的共享、修改和重新使用等环节。

近年来,随着生成式人工智能快速发展,AI内容愈发真实,AI换脸、AI变声等新型诈骗也层出不穷,确保数据安全和内容真实性也成为全球共识。中国相继出台《关于加强科技伦理治理的意见》、《互联网信息服务深度合成管理规定》、《生成式人工智能服务管理暂行办法》等多项法规和政策;4月23日,中央网信办再次强调要加强信息来源标注展示,使用AI等技术生成信息的,必须明确标注系技术生成。

编辑/樊宏伟