3月1日晚间,刘德华电影公司@映艺娱乐发布声明:

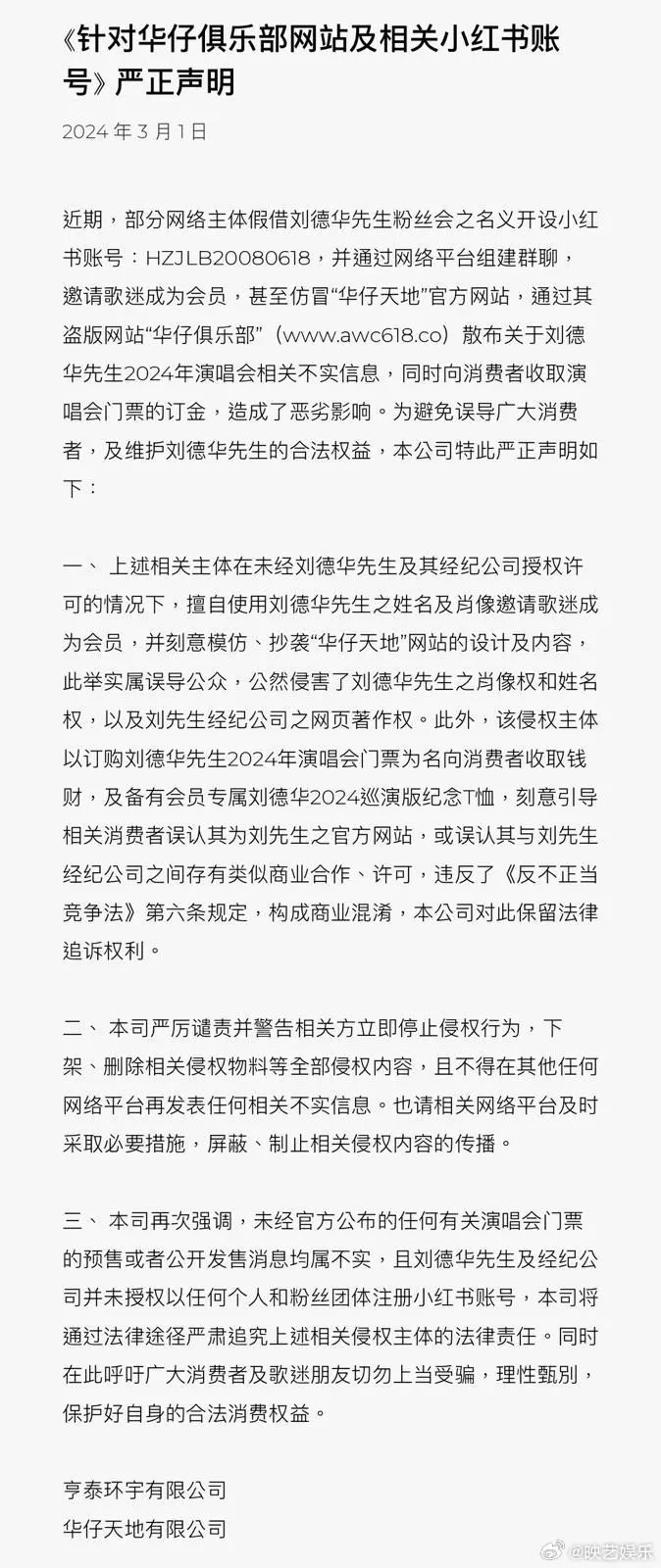

近期,部分网络主体假借刘德华先生粉丝会之名义开设小红书账号:HZJLB20080618,并通过网络平台组建群聊,邀请歌迷成为会员,甚至仿冒“华仔天地”官方网站,通过其盗版网站“华仔俱乐部”(www.awc618.co)散布关于刘德华先生2024年演唱会相关不实信息,同时向消费者收取演唱会门票的订金,造成了恶劣影响。为避免误导广大消费者,及维护刘德华先生的合法权益,本公司特此严正声明如下:

20分钟后,该账号再次发布《关于AI合成声音侵权事件的严正声明》:

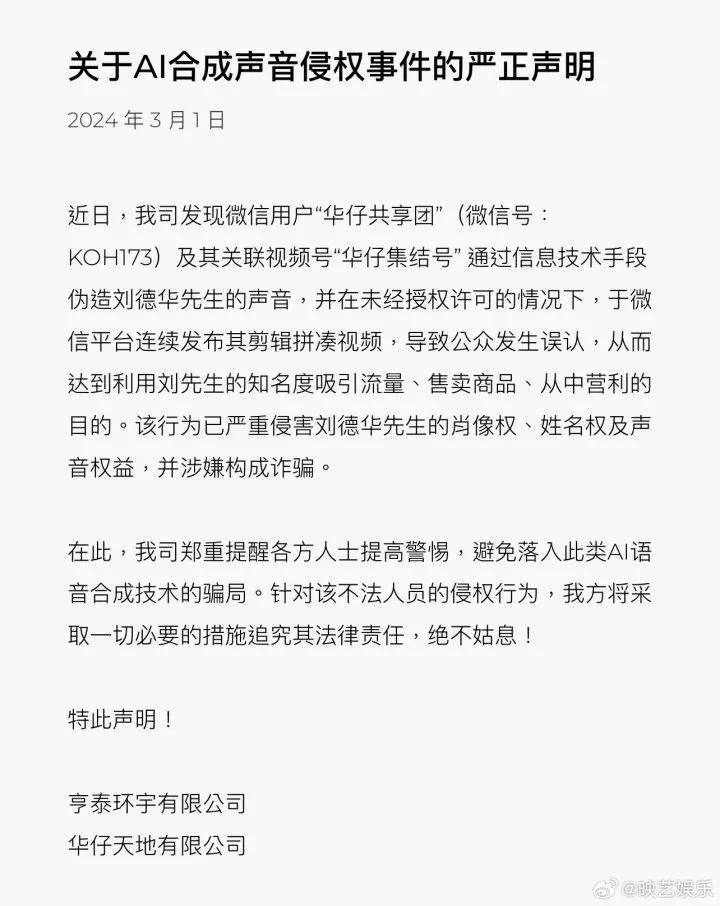

近日,我司发现微信用户“华仔共享团”(微信号:KOH173)及其关联视频号“华仔集结号”通过信息技术手段伪造刘德华先生的声音,并在未经授权许可的情况下,于微信平台连续发布其剪辑拼凑视频,导致公众发生误认,从而达到利用刘先生的知名度吸引流量、售卖商品、从中营利的目的。该行为已严重侵害刘德华先生的肖像权、姓名权及声音权益,并涉嫌构成诈骗。

近年来,“AI换脸”诈骗层出不穷。去年11月,国家金融监督管理总局北京监管局发布谨防“AI换脸”等新型欺诈手段的风险提示。

AI如何做到在视频通话时换脸呢?记者在一家为公安机关提供技术支持的科技公司看到的演示,相似度可以达到80%。

记者在现场看到,一个高配置的电脑,合成一段10秒的换脸视频只需要一两分钟。而技术的发展,上述案件中视频聊天的实时变脸也不是难事了。

广东深圳某科技公司产品部经理刘远洋表示:“照片上传后,大概有30秒的时间对照片进行特征识别,然后建模,建模后就可以进行实时转换。不管是你的头像,还是你在朋友圈的一张小照片,都可以直接上传。”

AI生成的技术还在不断更新迭代,比如性别的互换、声音的变换,都可以同步进行。由于算法是开源的,也就是说一个普通的工程师就可以制作出一个变脸软件,这就在控制源头上带来了极大的困难。

不断迭代的AI技术,已经把换脸视频做到“真假难辨”,我们应该如何防范此类新型诈骗呢?

监管部门也提醒市民:

网络渠道“眼见”不一定为实。“拟声”“换脸”等合成技术的一大特点即“以假乱真”,不法分子可利用此类技术轻易伪装成他人,并通过快速筛选目标人群、定制化诈骗脚本,精准实施诈骗。因此,在涉及资金往来时,一个“声音很熟的电话”、一段“貌似熟人的视频”都可能是不法分子的诈骗套路;

转账汇款务必核验对方身份。面对自称“熟人”“领导”等通过社交软件、电话等以各种理由诱导汇款,务必核验对方身份。如可在沟通过程中提问仅双方知晓的问题,也可利用其他通讯方式或见面核实,或向对方的朋友、家人验明身份和情况。在无法确认对方身份时,应尽量避免转账操作;

保护好照片、声音等个人信息。消费者应提高个人信息保护意识,不随意下载陌生软件、注册陌生平台或添加陌生好友,对个人社交账户的安全状况保持警惕。尽量避免在互联网过多暴露个人照片、声音、视频等信息,不贪图方便把身份证、银行卡照片等直接存放在手机内。如不慎被骗或遇可疑情形,应注意保存证据并立即向当地公安机关报案。

综合自央视财经、中央广电总台中国之声、@映艺娱乐

编辑/田野