当地时间6日,美国半导体设计公司AMD首席执行官苏姿丰表示,AMD针对生成式人工智能(AIGC)设计的MI300X芯片是“业界最先进的人工智能加速器”,并声称其性能优于英伟达H100型AI芯片。

在这场名为“Advancing AI”的特别活动中,AMD首席执行官苏姿丰推出两款MI300系列AI数据中心芯片:一款专注于生成式AI应用,型号为MI300X;另一款名为MI300A,将图形处理功能与CPU相结合,主要面向超级计算机。

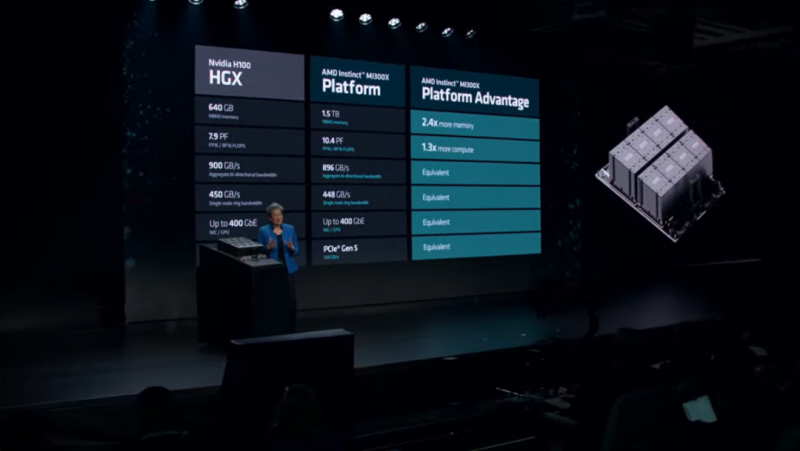

苏姿丰在演讲中直接将Instinct MI300X GPU与英伟达H100 GPU进行性能对比,并表示在训练性能方面,MI300X 与竞争对手(H100)不相上下。同时AMD的产品在推理工作负载方面表现更为出色。

图片来源:AMD公司Advancing AI活动直播截图

她表示,“Instinct MI300X 平台支持与竞争对手相同的连接和网络功能。相比英伟达H100 HGX,它具有2.4倍以上的内存、1.3倍以上的计算能力,”是“业界最先进的人工智能加速器”。不过这一说法还未得到独立验证。

《福布斯》杂志对此表达了怀疑,因为“现实中人工智能应用程序会(比实验室状态的表现)稍微慢一些”。

在演讲过程中,苏姿丰并没有将MI300系列产品与英伟达11月发布的H200芯片的性能进行比较。此前的英伟达发布会显示,其新推出的H200,性能相较前代H100提升60%到90%。

根据计划,明年上半年英伟达将向市场大量投放H200并逐步开始取代H100芯片。

据路透社援引分析师估计,英伟达目前已经占据了大约80%的AI芯片市场,这包括其为谷歌和微软等公司生产的定制处理器。

然而,这并不意味着英伟达能够长期确保其在AI芯片领域的领先地位。

由于芯片制程提升导致的短沟道效应以及量子隧穿效应带来的发热、漏电等问题已经严重影响了缩微器件的性能,目前集成电路行业已经进入到了后摩尔时代。

为保障芯片性能的不断提升,AMD 是第一个引入chiplet架构并进行商业化的厂商,其最新几代产品都极大受益于“SiP + Chiplet”的异构系统集成模式。

此次发布的MI300X芯片基于全新AMD CDNA 3构架,采用chiplet设计,并应用了台积电SoIC 3D片间堆叠和CoWoS先进封装技术。这使其结合了1530亿个晶体管,支持高达192GB的HBM3内存,提供大型语言模型推理和生成AI工作负载所需的算力和内存效率。

据悉,英伟达尚未推出采取类似技术路线的AI芯片,而更多的采用2.5D封装技术路线。根据计划,英伟达将在明年推出采用和AMD300系列芯片类似技术路线,基于Blackwell架构的下一代AI芯片GB100。

在会上,苏姿丰在会上对新芯片未来的市场前景表现出了乐观。她预计AMD 明年会供应“大量”AI 芯片,其价值“远高于”20 亿美元。

根据澎湃新闻报道显示,微软首席执行官萨提亚·纳德拉(Satya Nadella)上个月曾表示,该公司的微软云(Azure)服务将首先提供AMD新型MI300X AI芯片。除此之外,AMD透露使用这些处理器的客户包括甲骨文和Meta,OpenAI也称将在最新版本的Triton AI软件中整合AMD的新芯片。

图片来源:AMD公司Advancing AI活动直播截图

苏姿丰同时还看好AI芯片市场发展前景,她认为AI芯片市场整体依旧会保持高增速,称到2027年,AI芯片市场可能会增长到4000亿美元。

根据著名数据网站Statista估算,AI芯片市场规模在2022年刚达到442亿美元。

值得注意的是,AMD和英伟达都同时受到美国最新对华出口规则的制约。对于这个问题,据《金融时报》报道,苏姿丰在现场接受采访时称AMD“花了很多时间与(拜登)政府”和美国商务部打交道。

“我们知道,从国家安全的角度来看,对于最先进的芯片来说,(出口限制)对我们来说很重要。”她说,重要的是“找到平衡点”。

此前,苏姿丰在AMD三季度财报电话会议上表示,AMD看到了中国人工智能市场的销售潜力,并称“我们正在为寻找人工智能解决方案的中国客户群开发产品”。

编辑/樊宏伟